你知道机器人的三大法则吗(如何让机器人遵守)

人工智能的进化速度会比人类更快,而它们的未来还不可预测。

—— (英)斯蒂芬·霍金

高考成绩出了,几家欢喜几家愁。选专业报专业,眼下人工智能专业却是最热门的。很多大学都是去年年底和今年上半年才设立的人工智能学院。先看看这赶着开班的名单,2017年先后有:中国科学院大学、西安电子科技大学、苏州大学、南宁学院等;2018年先后有:湖南工业大学、上海交通大学、重庆邮电大学、南京大学、长春理工大学、哈尔滨工业大学、天津大学、南开大学、辽宁工程技术大学、杭州电子科技大学、吉林大学等。

人工智能的风波不止如此。前段时间传出美国花旗集团投行业务技术和运营员工最多要裁一万人,也就是说在花旗上班的一半人都要下岗。之前谁要是进到花旗工作,那就是走上了一条拿钱铺成的路,是精英中的精英,没想到风向说变就变。难道是投行面临行业严冬,全世界又要经历一场十年前那样的金融危机?花旗银行总裁表示,花旗银行40%的运营岗位,完全是可以用智能机器人来替代的。之前富士康集团也是大规模裁员,除了苹果的订单减少的原因,还因为改进了生产过程,也用机器人代替了一些人工步骤。

小编曾经被知乎的“中年失业”帖子吓破了胆子。如今一看,先不提比自己更优秀的年轻人辈出,就连人工智能也来抢饭碗了,可不知如何是好。在英美合拍的主题是人工智能的电视剧《真实的人类》里,小编所担心的事情变成了事实,仿真机器人在各处挤占了人类的岗位,大批人类失业者无所作为。而在同样是大热人工智能剧的《西部世界》里,剧情和《真实的人类》一样,都走向了相同的趋势:那就是仿真机器人开始拥有人性,他们比人类更聪明、更具优势,开始起身反抗人类。

人类的进步发展,离不开工业革命和机器的诞生,自从机器被创造之后,人们就把机器当作比手更便利的工具使用。让传播学家麦克卢汉来说,机器也是一种媒介,是人的延伸。那么假如这种媒介反噬人类,不仅让人类依赖,而且蜕变进化成为比人类更高级的物种会怎么样?

“机器人游行,要求获得公民权利”“恐怖分子的虚拟化身炸弹袭击假日场所”“诺贝尔文学奖颁给IBM的深蓝朵拉”“针对机器人解放部队的种族灭绝指控”“虚拟交易员在股市敛财”“联合国就禁止人工智能自我复制展开辩论”“连环杀人犯经查是咖啡厅的值班机器人”……

假如上述标题在新闻上看到,你会怎么想?再假如如果你看到“人类为机器人无偿提供劳动的法律今天被通过”的此类标题又会怎么想?当然这些都是小说家才回去构想的事件,我们看看小说和电影也就算了,又怎么会当真呢。可是从来就没有绝对不会发生的事情,只有发生几率的大小。计算机的诞生被称为科学的奇迹和第三次工业革命,人类第一次登上月球也被成为是人类发展史上的奇迹,但是它们都发生了。我们从对奇迹不可思议到习以为常,只花了不到一百年的短短时间。机器人进化为具有人工智能的生物也从没人敢想到被人当成文学和影视的故事素材。

科幻小说家阿西莫夫在小说《我,机器人》里制定了机器人的三从四德,希望这些定律可以保证机器人的正确发展。第一定律:机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管;第二定律:机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;第三定律:机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存。

阿西莫夫

可是这些规定却是非常模糊不清的,第一定律就违反了逻辑,比如一个犯了反人类罪的人(假设是希特勒),那么机器人会怎么对待希特勒呢?或者在校园枪击事件中,机器人应该作何反应呢。如果是人类警察,就会击毙狙击的枪手。可是阿西莫夫逻辑下的机器人一方面不能伤害人类个体,另一方面又不能目睹人类个体将遭受危险而袖手不管。在此种情况下,机器人到底应该应该做些什么?第二定律更是莫名其妙,那么假如机器人是机器人,假如人类命令机器人为希特勒执行死刑,如果机器人不能做到以上那一点,又怎么能保护和不伤害人类个体呢?所谓伤害人类个体是怎样一种伤害?柯洁和阿尔法狗下棋,输得一塌糊涂,柯洁算不算被机器人伤害了情感?伤害的范围又是什么呢?

阿尔法狗和柯洁

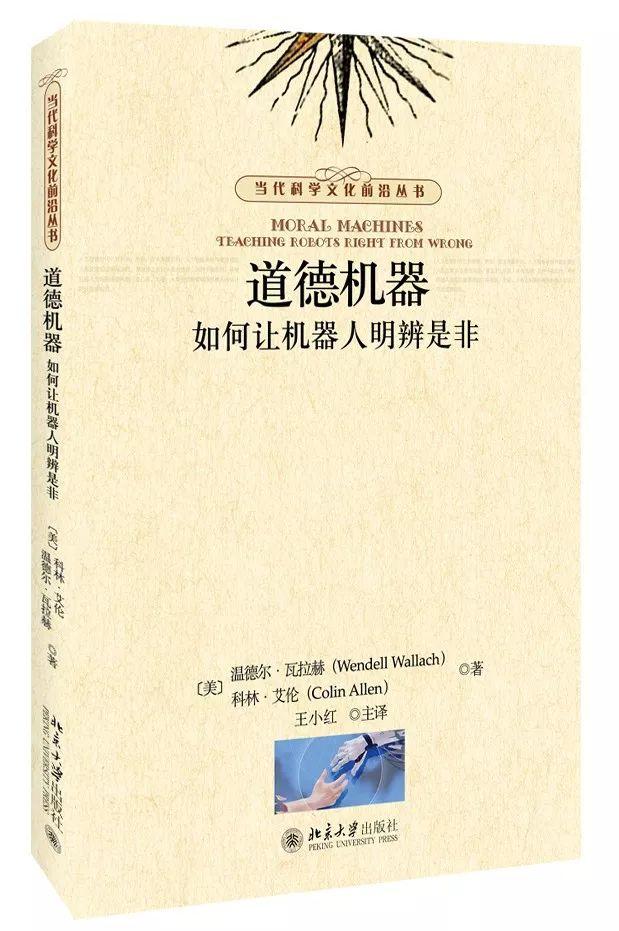

当然阿西莫夫的机器人三大定律都只是科幻小说家的一人之言,仔细考虑一下,就会发现有很多的漏洞。人工智能和神经科学伦理学领域的专家温德尔·瓦尔赫提出了要制造一种人工道德智能体(Artificial moral agents),简称AMAs,这个理论探讨了机器人应该具备怎样的符合人类利益的道德。瓦尔赫在《道德机器——如何让人类明辨是非》一书中提出了几种让机器人具备道德的方法,其中包括自上而下式和自下而上式。

自上而下就是程序员帮系统设计好道德模式,当系统适应了这种道德模式,就把它扩展到其他小的模块里,就是像中央说了要怎么办,各地地方政府就去学习中央精神。自下而上就是把系统放在真实环境里,让它学习道德,然后慢慢习惯,就算犯错了也没关系,学会了就行。同样,言传身教是一种教育方法,在学校里跟同辈优秀的同学学习也是一种教育方法。瓦尔赫的想法是让自上而下和自下而上相结合,多手段相结合,才能确保疏而不漏,也是最稳妥的。

把机器人当成人类的幼童一样去教导,让人工道德智能体更像人类一些,那么机器人或许就能学会人类世界的处事原则。在《道德机器》中,作者还介绍了一个叫LIDA的理论模型,类似于把人类的思想活动模式化。比如你在救人之前,会有一番思想活动,最后这番思想活动使你踏出救人的那一步,小的时候学校会教“学习雷锋好榜样”,家长会教“帮助别人是正确的”,那么一遍一遍就会构成一个循环,在救人的一瞬,或许会想到万一被赖上咋办,但是,这些反对会被之前的助人为乐教育给压下去,救人的方案就会呈现给行动选择机制。LIDA就会在机器人身上反复强调“助人为乐”这个节点,弱化“被人赖上”这种负面事件,“助人为乐”就会成为自动程序。LIDA的模型还只在设想阶段,它也必须面对是不是能在各种多样复杂的情况下有效的挑战。

如果让机器人具备人类道德,那么很重要的一点是:如何让机器人具备同理心。如果机器人有同理心,那么它必须是能感知人类情绪的。在《道德机器》中,作者同样也探讨了如何让机器人有情感计算的能力,首先是要能检测到情绪,那就是利用面部动作编码系统去追踪面部肌肉的运动;其次是让人工智能去使用情绪,小编倒是挺想看到一个机器人发脾气时什么样子的。

神话里的神都是和人类长得差不多的,人类无意识根据自己本身的形象去创造未知的事物,已经成为了一种习惯,小编对仿真人工智能的出现抱有很大的期望,而即便是长得一模一样的双胞胎在长大之后,也会自主去分开、和表现自身的独特性。如果真的有上帝,那么上帝是按照他自己的样子去创造人类的;如果真的有机器人,那么它或许有人的外表。如果人类要区分自身和仿真人工智能,那么就应该在人工智能的道德上下功夫,让它们学习到我们的道德,但千万不要让它们有我们的灵魂。

(文/兰德尔)

《道德机器:如何让机器人明辨是非》

作 者:[美]W.瓦拉赫,C.艾伦 著

要把智能机器人,

永远关在道德的牢笼里!

,